Wie man indexierte URLs findet, die für Google in der Robots.txt blockiert werden

Wie Sie dieses technische SEO-Problem in URLinspector erkennen können

- Machen Sie nicht den Fehler, eine indexierte URL in der

robots.txtzu blockieren - URLinspector zeigt Ihnen genau, wo das passiert ist - basierend auf den Daten, die der Google-Bot selbst zur Verfügung gestellt hat.

- Wenn Sie wollen, dass eine URL de-indexiert wird, verwenden Sie das

noindex-Attribut.

Wie Sie dieses technische SEO-Problem in URLinspector erkennen können

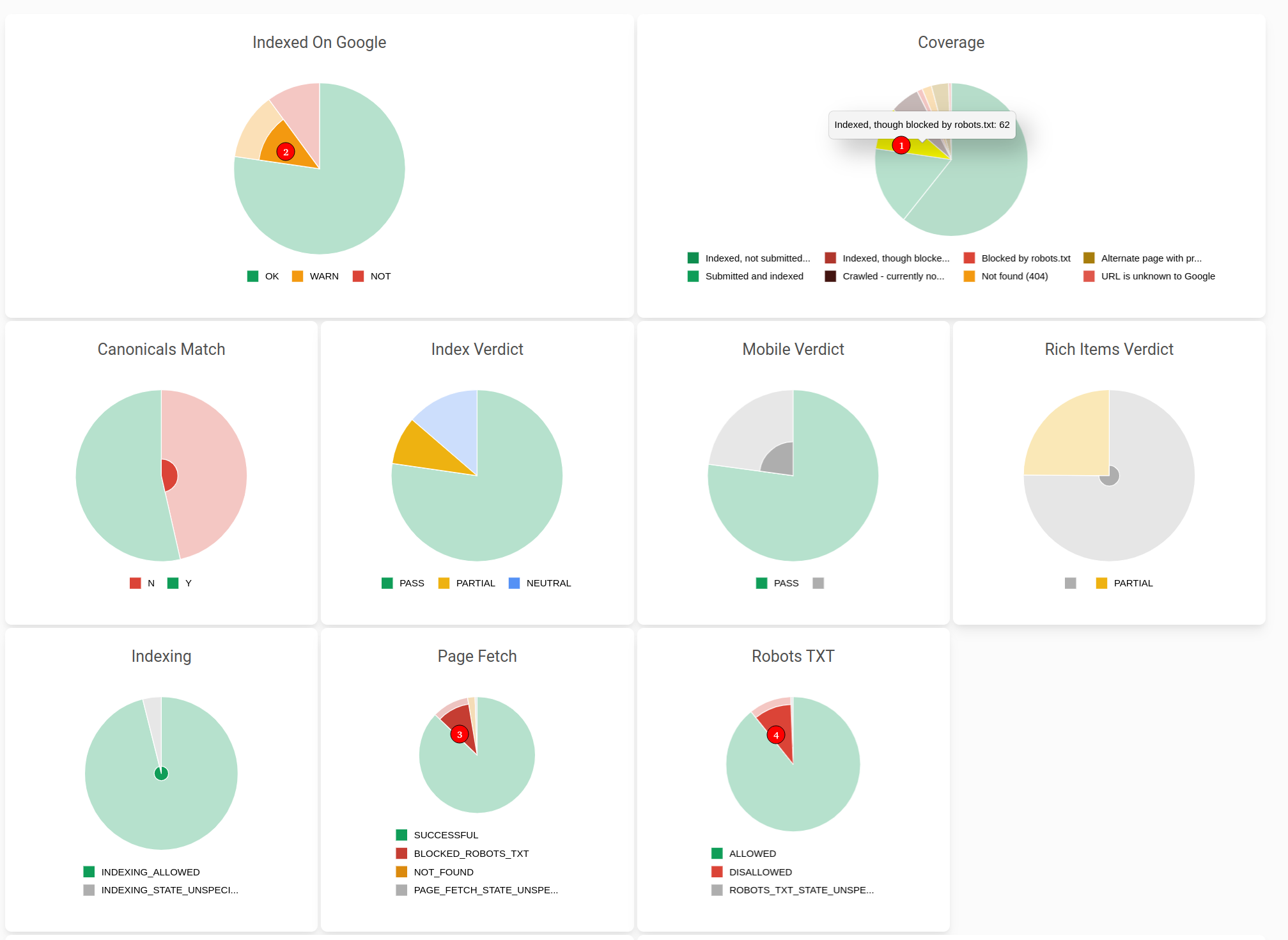

Wenn Sie im URLinspector den Status Indexed, tough blocked by robots.txt sehen, dann ist Ihre Website möglicherweise in Gefahr.

Dieser erste Hinweis auf bereits indexierte Seiten, die nun in robots.txt blockiert werden, kann dazu führen, dass Sie mit der Zeit alle Rankings verlieren.

Werfen Sie einen Blick auf den Screenshot unten:

We see:

Wir sehen:

(1) Coverage-Diagramm “Indexiert, aber durch robots.txt blockiert”

(2) eine WARNung in der Tabelle “Indexed by Google”.

(3) Status “Blocked Robots.txt” im Diagramm “Page Fetch” (Ergebnis des Seitenabrufs durch Googlebot)

(4) Status “DISALLOWED” in der Tabelle “Robots TXT status”.

Hinweis: Wenn Sie auf diese Diagramme in der URLinspector-App klicken, erhalten Sie eine vollständige Aufschlüsselung in einer Tabelle wie hier.

Kontext dieser robots.txt, die Google von indizierten URLs ausschließt

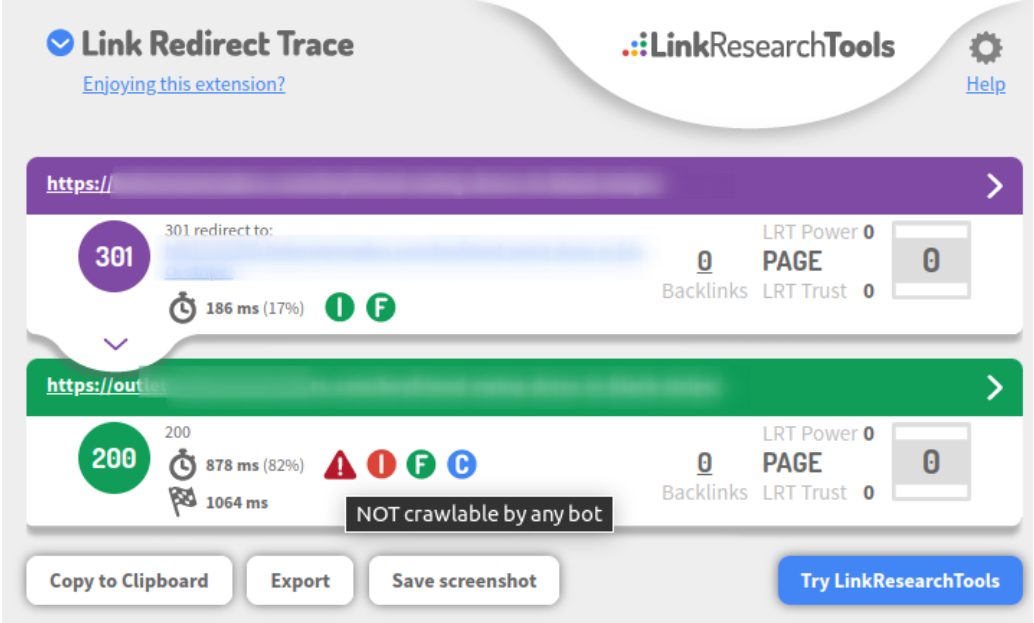

Das Problem ist, dass dieser E-Commerce-Shop einige www-URLs hat, die jetzt auf eine Subdomain umleiten, die von Bots blockiert wird.

Wir können dies auf einer einzelnen URL-Basis auch in der beliebten kostenlosen Browsererweiterung Link Redirect Trace deutlich sehen.

Wir sehen also, dass die www-URLs von den URLs, die in den blockierten Bot-Bereich umgeleitet werden, de-indexiert werden.

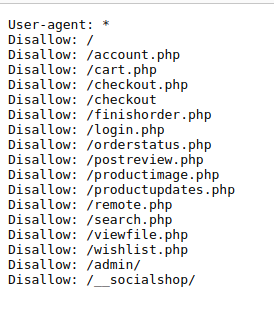

Wenn wir uns die Datei robots.txt der Subdomain ansehen, sehen wir, wie sie alle URLs bereits in den ersten beiden Zeilen blockiert

User-Agent: *

Disallow: /

Was hier wahrscheinlich erwünscht war, war die Blockierung der Root-URL “/”.

Leider ist das nicht wie robots.txt funktioniert.

Die Lösung für dieses Google SEO Problem

Die Lösung ist schnell und einfach:

- Entfernen Sie die Sperre für alle URLS - d.h. “Disallow: /”

- Warten Sie, bis Google alle URLs neu erfasst hat, oder stellen Sie eine Anfrage, um sie manuell zu indizieren.

Wenn Sie eine URL bei Google deaktivieren möchten, müssen Sie das Attribut noindex verwenden.

Was ist Ihr Problem mit der Google-Indexierung?

Lassen Sie es uns wissen, indem Sie an @URLinspector twittern und wir werden es gerne in einem der nächsten Beiträge behandeln.